本篇目录:

python中怎么安装jieba库

首先打开谷歌浏览器如图示输入地址,打开jieba下载首页。点击”Download files“并点击”jieba-0.4tar.gz “下载。将其解压到指定目录,我这里为了演示方便解压到python的安装目录。

首先点击桌面左下角的开始图标,然后选择运行。(推荐教程:Python入门教程)在弹出的窗口中输入cmd,然后点击确定。输入:pip install jieba,然后按下回车键会自动开始安装。

python实现 python中需安装jieba库,运用jieba.cut实现分词。cut_all参数为分词类型,默认为精确模式。

mac也有终端呀,都是一样的,mac,linux,windows安装Python包都是pip install 包名就行了。

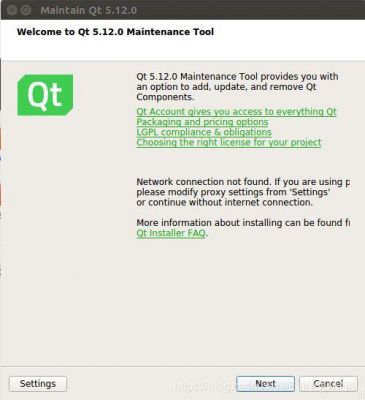

本以为 安装 jieba是个超级简单的事情。在Python上直接安装 很方便,直接pip install jieba 但在anaconda上安装 时候用conda install jieba 报错。

jieba库怎么安装

1、首先打开谷歌浏览器如图示输入地址,打开jieba下载首页。点击”Download files“并点击”jieba-0.4tar.gz “下载。将其解压到指定目录,我这里为了演示方便解压到python的安装目录。

2、首先点击桌面左下角的开始图标,然后选择运行。(推荐教程:Python入门教程)在弹出的窗口中输入cmd,然后点击确定。输入:pip install jieba,然后按下回车键会自动开始安装。

3、直接安装只需要几分钟。jieba库是第三方中文分词函数库,需要额外安装,Pycharm自带有下载选项,直接安装步骤下载使用即可。

4、jieba不是PyCharm自带的包。需要使用PyCharm内置的PackageManager来下载jieba,可以从PyCharm设置里找到这个功能,或者也可以使用命令行工具安装jieba,例如pipinstalljieba。

5、升级pip命令: python -m pip install --upgrade pip 如果已经下载了jieba安装文件就使用:pip install 文件名 如果没有下载就使用:python -m pip install --user 模块名,系统自动下载 如果没有安装pip,先安装pip。

如何利用Python对中文进行分词处理

1、自然语言处理(NLP)在数据分析领域有其特殊的应用,在R中除了jiebaR包,中文分词Rwordseg包也非常常用。

2、逐词遍历法。把词典中的词按照由长到短递减的顺序逐字搜索整个待处理的材料,一直到把全部的词切分出来为止。不论分词词典多大,被处理的材料多么小,都得把这个分词词典匹配一遍。设立切分标志法。

3、字符串可以直接分片或者索引访问,比如s[0]=我,s[-1]=做。等等。如果是要转成list,可以直接构造,如: l=list(abc)或者l=list(s)分词需要相应的算法和词典支持。pymmseg-cpp是一个不错的python中文分词库。

4、中文和英文主要的不同之处是中文需要分词。因为nltk 的处理粒度一般是词,所以必须要先对文本进行分词然后再用nltk 来处理(不需要用nltk 来做分词,直接用分词包就可以了。严重推荐结巴分词,非常好用)。

5、可以利用python的jieba分词,得到文本中出现次数较多的词。

6、中文分词方法可以帮助判别英文单词的边界。 doc3 = 作用中文分词是文本挖掘的基础,对于输入的一段中文,成功的进行中文分词,可以达到电脑自动识别语句含义的效果。

到此,以上就是小编对于python的jieba库教程的问题就介绍到这了,希望介绍的几点解答对大家有用,有任何问题和不懂的,欢迎各位老师在评论区讨论,给我留言。

微信扫一扫打赏

微信扫一扫打赏